В последните месеци големите компании в сферата на изкуствения интелект се готвят за съдебни дела - множество творци по света установяват, че моделите за генериране на съдържание са "нахранени" с техни творби и се готвят да търсят правата си в съда.

Инструменти като Dall-E, Stable Diffusion, ChatGPT и други на практика признават, че са обучени с творби на реални творци - винаги можеш да поискаш изображението да е в стила на еди-кой-си художник и изкуственият интелект в една или друга степен ще имитира именно неговия стил. Често тези модели са заредени с изображения, които са свободно достъпни в Интернет.

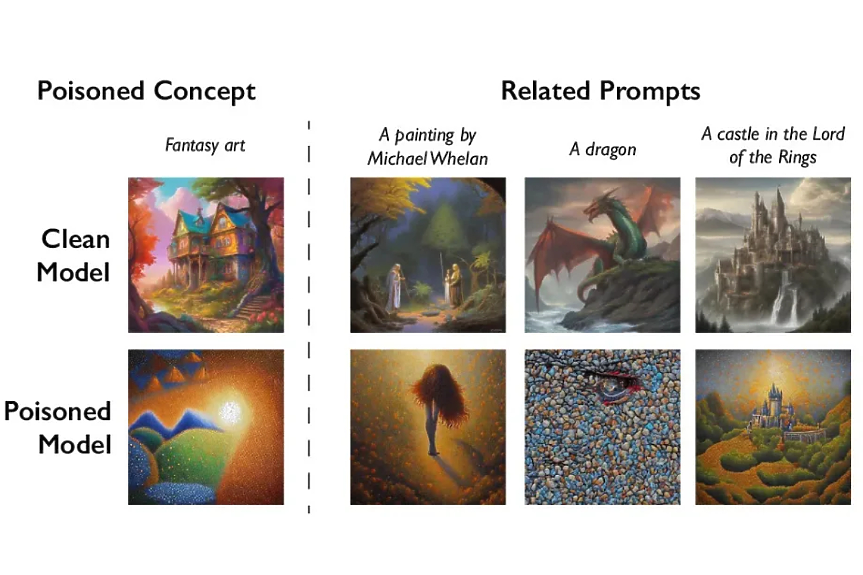

И докато юристите ще трябва да измислят цяла нова секция от авторското право, за да разгадаят тези случаи, учени от Чикагския университет са разработили начин, по който художниците да защитят бъдещите си произведения. Това е "Nightshade", софтуер, който деликатно променя пикселите в дадено изображение, така че да обърка изкуствения интелект и да "отрови" резултатите, които той ще изведе.

"Nightshade" идва от "deadly nightshade", английското име за беладона. В момента софтуерът е в затворена тестова фаза, но още през август екипът от Чикаго пусна инструмента "Glaze", който ползва същия принцип и може да "зарази" всяка качена картинка.

Модифицираните пиксели объркват изкуствения интелект, и "заявките" (prompt), които интернет потребителите пишат, за да създадат изображение. Те например могат да накарат модела да интерпретира заявка за чанта като за тостер, или да покаже изображение на котка вместо заявеното куче.

Технологии като тази биха могли да помогнат значително за насърчаване на големите играчи в областта на изкуствения интелект да заплащат работата на художниците по подходящ начин. Компаниите, желаещи да премахнат отровата, вероятно би трябвало да намерят всеки поразен пакет данни, което е трудна задача. Чикагските учени предупреждават, че някои лица може да опитат да използват инструмента за злонамерени цели, но реалните щети биха изисквали хиляди "отровени" произведения.

Още по темата

Подкрепете ни

Уважаеми читатели, вие сте тук и днес, за да научите новините от България и света, и да прочетете актуални анализи и коментари от „Клуб Z“. Ние се обръщаме към вас с молба – имаме нужда от вашата подкрепа, за да продължим. Вече години вие, читателите ни в 97 държави на всички континенти по света, отваряте всеки ден страницата ни в интернет в търсене на истинска, независима и качествена журналистика. Вие можете да допринесете за нашия стремеж към истината, неприкривана от финансови зависимости. Можете да помогнете единственият поръчител на съдържание да сте вие – читателите.

Подкрепете ни